31 Mar 2025 9

Versión 4.1. SMART Demand Forecast: la previsión se ha vuelto aún más cómoda

Incrementar la precisión de las previsiones de la demanda es fundamental para una gestión eficaz del inventario, optimización de los procesos de producción y mejora de los resultados financieros. En concreto, la capacidad de pronosticar correctamente la demanda ayuda a reducir el exceso de inventario, evitar la escasez de productos y, por último, aumentar los beneficios de la empresa.

Actualmente, el sistema de previsión de la demanda es una herramienta clave para la competitividad de los actores del mercado de todos los tamaños. Con la nueva versión 4.1, hemos hecho que SMART Demand Forecast sea más cómodo y rápido, permitiéndole obtener previsiones aún más precisas y desarrollar su negocio.

Veamos las actualizaciones principales.

Se ha implementado el despliegue parcial de la infraestructura por bloques separados

Hemos implementado un despliegue parcial de la infraestructura por módulos separados, lo que permite reducir el coste de los recursos de la nube, especialmente en la fase piloto de la previsión.

Se ha realizado la migración de las funciones a .Net Isolated

Se ha mejorado la seguridad y el rendimiento del sistema al migrar la función a .Net Isolated y al actualizar la configuración de Azure Function. Esto garantiza un soporte estable de la solución por parte de los desarrolladores, simplifica la implementación de las actualizaciones y mejora significativamente el nivel de seguridad y el rendimiento del sistema.

Se ha actualizado el sistema a .NET 8.0

Se han introducido cambios en una serie de componentes del portal para implementar importantes actualizaciones del sistema. La actualización de la plataforma a la última versión de .NET mejora la estabilidad, aumenta la velocidad de trabajo y permite el soporte de las últimas capacidades tecnológicas.

Se han realizado cambios en la configuración de Azure Function

Hemos optimizado la infraestructura al trasladar Azure Function a AppService Plan compartido. Esto nos ha permitido reducir el coste de los componentes de la nube y simplificar la gestión de los recursos, garantizando un funcionamiento estable del sistema a un coste más bajo.

Se ha realizado la migración del modelo analítico de SQL dedicated pool a Databricks

Como parte de la modernización del modelo analítico, se ha realizado la migración de las computaciones a Spark y el almacenamiento de los datos en Datalake. Esto permite ampliar la solución para trabajar con cálculos y grandes conjuntos de datos sin perder el rendimiento.

Se han optimizado los cálculos de indicadores de DAX Power BI

Las consultas optimizadas y la estructura de almacenamiento de datos actualizada permiten reducir el uso de los recursos y acelerar la generación de informes.

Se ha realizado una optimización global del modelo analítico

Hemos realizado una optimización global del modelo analítico, que mejora significativamente la eficiencia de los procesamientos de datos y ETL. Esto significa una carga, procesamiento y análisis más rápidos de grandes volúmenes de información.

Se han transferido las fuentes de datos de Power BI a las tablas Delta

Hemos aplicado el cambio de fuentes y conexiones que ha sido posible al optimizar el modelo analítico. Esto nos ha permitido optimizar el almacenamiento y acelerar las consultas analíticas. Este cambio reduce la carga del sistema, disminuye los costes de procesamiento de datos y aumenta la velocidad de funcionamiento de los informes analíticos.

Se ha mejorado la importación y exportación de archivos

Hemos estandarizado y optimizado los procesos de importación y exportación de archivos, lo que ha permitido automatizar la comprobación de su estructura. Esto significa menos trabajo manual, menor riesgo de errores y mayor calidad de los datos cargados. De este modo, trabajar con archivos resulta más rápido, sencillo y eficaz para su negocio.

Se ha añadido la funcionalidad de administración de las campañas promocionales

La nueva funcionalidad permite introducir de forma rápida y cómoda los datos para todos los puntos de venta en una sola línea. El sistema distribuirá automáticamente la información entre cada punto de venta, minimizando el riesgo de errores. Esto acelera considerablemente el proceso de gestión de las campañas y aumenta la eficacia de su equipo.

Se ha implementado la capacidad de detectar productos/tiendas que son nuevos en la analítica

Ahora puede gestionar la analítica de la manera flexible, excluyendo a los novatos de los cálculos de precisión de las previsiones. Esto permite evitar las distorsiones de datos que pueden producirse debido a un historial de ventas incompleto de los nuevos productos o tiendas. Con esta función, sus previsiones serán aún más precisas y sus decisiones administrativas serán más razonadas.

Se ha añadido la deduplicación a cada tabla de la estructura de datos universal

La calidad de datos es la base para una previsión precisa y una gestión eficaz de los procesos empresariales. Hemos implementado comprobaciones de duplicados en cada tabla de la estructura de datos universal, lo que permite evitar la duplicación errónea de la información. Esto aumenta la confianza en la analítica, garantiza la corrección de los cálculos y hace que el proceso de toma de decisiones sea aún más preciso.

Se ha elaborado un informe de ItemLifeCycle

El ciclo de vida del producto es un factor clave en la planificación del surtido, gestión del stock y la previsión de ventas. Hemos desarrollado un informe automatizado ItemLifeCycle, que proporciona una analítica detallada de cada fase del ciclo de vida del producto. Esto le permitirá tomar decisiones empresariales razonadas, optimizar las existencias y planificar las compras de forma más eficiente.

Se ha mejorado la UX/UI y la usabilidad

Aunque el sistema está diseñado para realizar cálculos matemáticos precisos, no olvidamos que fue creado ante todo para los usuarios. Por eso mejoramos constantemente la forma de interacción con SMART Demand Forecast. Esto es lo que se ha implementado en esta versión:

- Se ha investigado e implementado Lazy Loading para optimizar la renderización de la interfaz.

Lazy Loading permite cargar primero sólo los elementos críticos de la página y cargar gradualmente los elementos no críticos, lo que es especialmente importante para los usuarios con conexiones de red lentas.

- Se ha optimizado el rendimiento de las páginas

Hemos reducido la cantidad de elementos en la página y hemos restringido las solicitudes de API a la hora de ejecutar los procesos empresariales principales. Las páginas visualizan sólo los indicadores de funcionamiento del sistema necesarios, y las solicitudes de API se ejecutan una vez finalizados los procesos importantes. Esto reduce la carga del sistema, lo que es importante para los usuarios con dispositivos menos potentes o conexiones de red lentas.

- Se ha añadido un cómodo panel de navegación de configuraciones

Se ha añadido una barra de navegación de las páginas principales en la interfaz de la solución. Esta actualización simplifica y acelera la navegación en el sistema y mejora la experiencia del usuario.

- Se ha mejorado la interactividad de la interfaz

Se ha mejorado la interacción de los usuarios con el sistema, haciendo que la interfaz sea más fácil de usar, dinámica y atractiva. Esto incluye mejoras en los elementos del sistema con los que los usuarios interactúan en su trabajo habitual – todas las herramientas necesarias se han hecho más accesibles.

- Se ha investigado e implementado Lazy Loading para optimizar la renderización de la interfaz.

Se han mejorado los algoritmos de aprendizaje automático

Se han perfeccionado los algoritmos de aprendizaje automático: hemos optimizado el código de los procesos Data Science, hemos acelerado el modelado y la puntuación, que sirven de base para elaborar previsiones. Esto se traduce en un mayor rendimiento de los modelos y cálculos más rápidos.

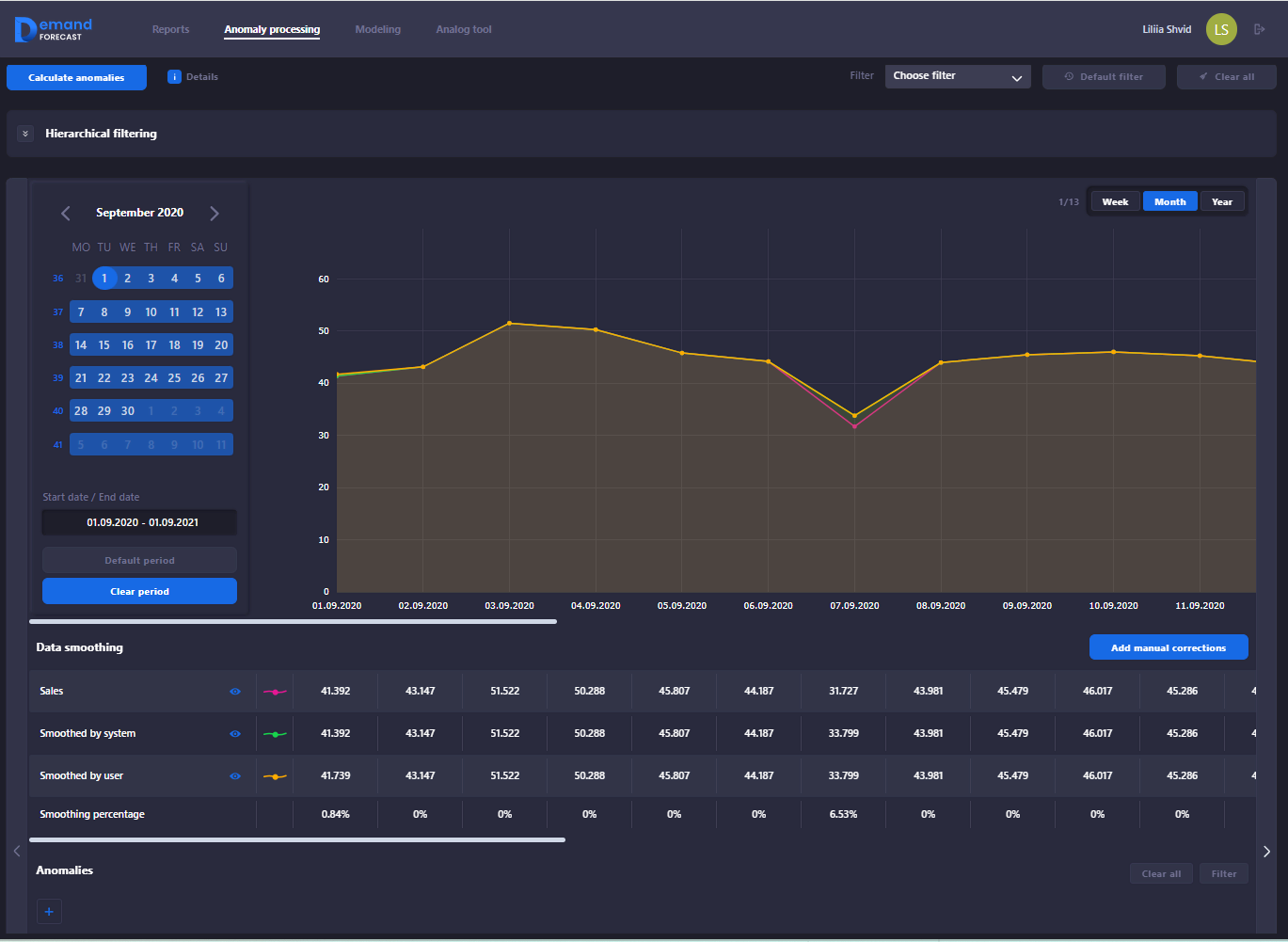

Se han abierto nuevas oportunidades en el manejo de anomalías

Las anomalías en los datos pueden distorsionar las previsiones, lo que da lugar a errores, por lo que trabajamos con ellas en cada versión. Estas son las áreas que hemos mejorado:

- Se ha optimizado el proceso de cálculo y descarga de anomalías

Se ha acelerado el registro en la base de datos de anomalías en un 30–40%. Gracias a la modificación de los procesos, los cálculos se realizan con mayor rapidez y el procesamiento de grandes conjuntos de datos se ha hecho aún más eficaz. Esto permite a la empresa responder rápidamente a situaciones inusuales y mejorar la calidad de las previsiones. - Se han perfeccionado los algoritmos de STL y Autoencoder

Esto ayuda a identificar mejor las desviaciones y a proporcionar previsiones más precisas. En consecuencia, puede gestionar los inventarios de forma más eficiente, optimizar los procesos en la cadena de suministro y reducir los riesgos financieros de su negocio. - Se ha optimizado el cálculo del periodo por defecto en la página de Procesamiento de Anomalías

Se ha introducido la comprobación del primer día de ventas para evitar la visualización de columnas vacías en las tablas. Ahora la selección del periodo es intuitiva y la visualización de los datos es más correcta.

- Se ha optimizado el proceso de cálculo y descarga de anomalías

Se han migrado los procesos Data Science de Azure Machine Learning a Azure Databricks

Esta migración permite trabajar con grandes volúmenes de datos de forma aún más rápida y eficiente gracias al marco de distribución optimizado para high-load tareas. Además, la migración abre las oportunidades de ampliación y reduce el coste de la solución.

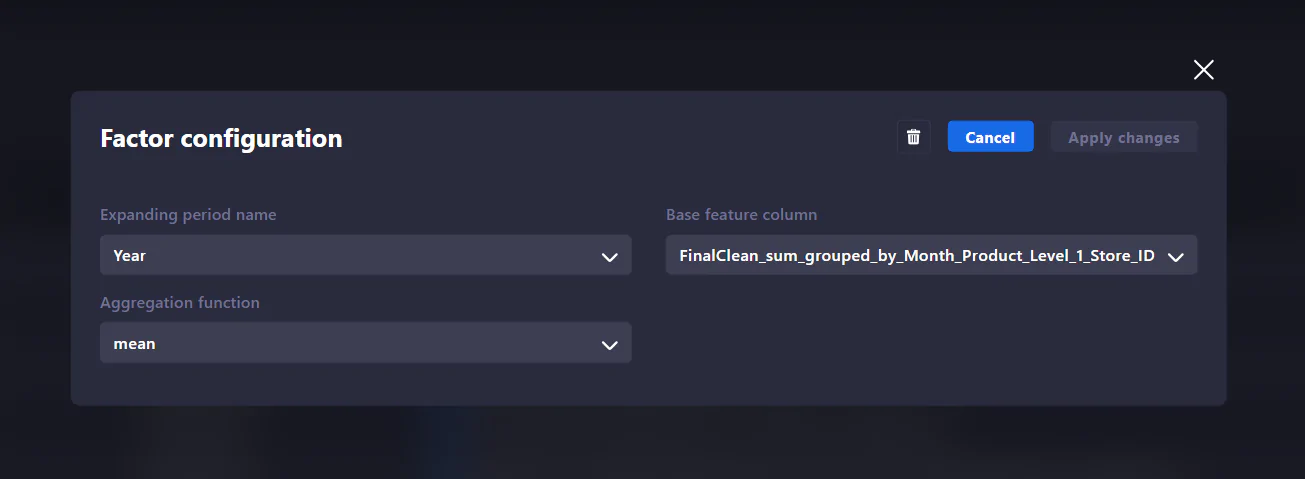

Se ha implementado una Cuenta en Data Science con el Constructor de Factores

El lanzamiento de una Cuenta de Data Science con un Constructor de Factores que se puede personalizar y guardar proporciona herramientas de modelado flexibles. La implementación del Constructor de Factores permite reducir significativamente el tiempo en la fase de experimentos piloto y reducir el posible factor humano durante las pruebas.

Se ha sustituido el modelo TFT por Prophet de Meta

Hemos perfeccionado los algoritmos de previsión sustituyendo el modelo TFT por el potente Prophet. Esto permite obtener previsiones aún más precisas y flexibles, mejorando la adaptación a la estacionalidad, tendencias y volatilidad del mercado.

Se ha adaptado la arquitectura a la previsión omnicanal

Realizamos análisis exhaustivos y preparación para todas las decisiones. Así, por ejemplo, hemos sentado las bases para futuras actualizaciones de nuestra previsión de ventas por canales, lo que nos permitirá analizar la dinámica de la demanda con mayor profundidad y optimizar nuestro surtido. De momento, esto nos da una idea más clara para descomponer la funcionalidad en la próxima versión.